1. 서 론

2. 센서 및 인지 알고리즘 구성

2.1. 차량 센서 구성

2.2. 인지 알고리즘 구성

3. 교차로 신호 인식 알고리즘 개발

3.1. 전방 교차로 신호기 추출

3.2. 전방 교차로 신호 색 인식

3.3. V2X 기반 전방 교차로 신호 값 수신

4. 신호기 색 인식 시뮬레이션 결과

4.1. 전방 교차로 신호기 색 인식 결과

4.2. 신호 인식 알고리즘 연산 시간 결과

5. 결 론

1. 서 론

자율주행 기술은 센서와 정보통신 기술의 발달로 운전자가 없는 Level 5의 완전자율주행을 목표로 발전되어 가고 있다. 이러한 자율주행 시스템은 차량 주변에 탑재되어 있는 센서로 주행 환경을 인지하고, 주변 환경속에서 자차량의 위치를 절대 좌표계 기준으로 측정하며, 인지된 데이터로 주어진 상황에 적합한 거동을 계획, 생성한 후 그 경로에 적합한 가감속 제어와 조향 제어를 진행한다.

이 중 동적 객체와 도로 정지 구조물을 인식하고 추정(DATMO)하는 것은 전체 자율주행 시스템의 가장 처음에 시작된다는 점과 그 결과값으로 차량의 거동이 계획되고 제어가 된다는 점에서 자율주행 시스템의 가장 핵심적인 부분으로 여겨진다. 실제 TESLA의 자율주행 기능에서 발생한 사고를 분석해보면, 전방 객체와 장애물 미인지로 인한 경우가 주를 이루고 있다는 점에서 인지기술은 자율주행 차량의 성능 및 안전 시스템에서 중추적인 역할을 담당한다고 말할 수 있다.(1) 이러한 인지 기술 향상을 위해, 라이다 센서 기반 객체 검출은 동적 객체에 대한 정확하고 빠른 추적 성능을 보여준다.(2) 또한, 이미지 데이터를 이용한 러닝 기반 알고리즘은 객체 탐지 및 분류 성능에 높은 정확성을 보인다.(3)

이러한 동적 객체 및 정지 장애물 인식하는 인지 기술은 자차량 주변의 환경을 인식하여 주어진 상황에서 최적화된 경로 생성 및 차량 제어를 진행하도록 하지만, 전체 교통 흐름을 파악하기는 어렵다는 단점이 존재한다. 도심도로의 경우, 자차량 주변의 차량들과 가드레일과 같은 도로 구조물을 인식하는 것 뿐 아니라 현재 신호 대기 여부, 과속 단속 카메라로 인한 규정속도 유지, 그리고 공사 구간으로 인한 의무 차선 변경과 같이 도로 환경 정보를 통해 최종 차량 제어를 해야 하는 경우가 빈번하다. 또한 고속도로의 경우 사고지역에 대해 우회 경로를 생성하여 차량 주행해야 하는 상황 또한 다수 존재한다. 그렇기에 현재 인지 음영 지역의 환경을 예측하고 차량의 거동을 계획하는 연구들이 지속적으로 진행중이다.(4) 더 나아가 도심 인프라를 통해 전체 교통 흐름 및 주행 도로 정보를 입력 받아 더 향상된 자율주행 성능을 목표하는 연구 또한 다양하게 진행되고 있다.(5,6)

본 논문에서는 이러한 교통 흐름에 대한 도심 인프라 정보 중 하나인 신호등 색 인식 알고리즘을 제안한다. 먼저 비전 오픈소스 알고리즘을 통해 인식된 객체 중 신호등만을 분별한다.(7) 그 중 자차량 경로에 영향을 미치는 전방 신호등만을 추출하여, 해당 데이터들의 이미지값을 통해 신호등 색을 인식한다. 제안된 신호등 색 인식 알고리즘은 도로의 인프라 활용 전략이므로, 자율주행 인프라 요소 중 하나인 V2X 데이터를 신호등 색 기준값으로 설정한 후 오프라인 시뮬레이션으로 검증한다. 2장에서는 자율주행 차량 인지 센서 및 전체 인지 알고리즘에 대해 기술하며, 3장에서는 교차로 전방 신호 인식 방법론에 대해 제안한다. 4장은 성능 평가를 위한 실차 데이터 기반 시뮬레이션 진행 결과 및 분석을 다루고, 5장에서는 결론 및 향후 연구 계획을 서술한다.

2. 센서 및 인지 알고리즘 구성

2.1. 차량 센서 구성

본 연구에서 제시하는 신호등 색 인식 알고리즘에 대한 성능 검증을 위한 실험차량의 센서 구성은 Table 1과 같이 나타내었다. 실험차량으로 전기차 Hyundai IONIQ을 이용하였으며, 전방 신호등 인식을 위해 Logitech Streamcam을 사용하였다. 또한 교차로 신호등 인식의 기준값으로써 ESSYS V2X장비를 사용하였다. 전방 카메라를 통해 인식된 이미지는 usb통신으로 pc에 기록되며, V2X의 경우 신호등에 있는 V2X단말기에서 송출하는 정보를 차량 내의 단말기(OBU)가 인식하여 PC로 데이터를 전달한다.

Table 1.

Sensor specifications

2.2. 인지 알고리즘 구성

자율 주행 차량의 인지 알고리즘은 Fig. 1과 같이 구성된다. 기존의 Detection and Tracking for Moving Object (DATMO) 성능을 위해 자율주행 차량 주변에 부착된 라이다 센서에서 환경 및 상황에 대한 데이터를 pointcloud 형태로 제공한다. 제공된 데이터를 통해 주변 동적 객체에 대한 트랙을 형성한다. 신호등 알고리즘은 기존의 트랙을 생성하기 위한 포인트 클라우드 처리 알고리즘과 별도로 카메라 데이터를 입력받는다. 입력받은 전방 이미지에서, 교차로 신호등을 인식 후 주어진 상황에서의 교통 신호 정보값을 출력한다.

본 논문은 카메라 인식 오픈소스 알고리즘이 제공하는 전방 데이터 인식값에서, 자차량의 교통 방향에 해당하는 신호등 정보값을 추출 후 그값의 픽셀값에 접근하여 해당 신호등의 신호값을 출력하는 프로세스에 대해 서술한다. 본 연구는 단순한 객체인식보단 도심 인프라 정보를 활용하는 것을 목표하기에, 제안된 알고리즘을 검증하기 위해 V2X 데이터를 수신하여 이를 신호등 색의 기준값으로 설정한다.

3. 교차로 신호 인식 알고리즘 개발

3.1. 전방 교차로 신호기 추출

카메라 데이터를 통해 전방 상황을 인식하기 위해 딥러닝 기반 객체 인식 오픈소스 알고리즘을 사용한다. 해당 알고리즘은 라벨링된 기준을 통해 전방의 객체들을 분류한다. 분류된 데이터 중, 전방 교차로 신호기에 대한 라벨링은 “traffic light”로 존재한다. 따라서, 인식된 전방 데이터 중, 본 연구에서 목표하는 교차로 신호등에 대한 정보는 인식된 각 객체가 “traffic light”인지에 대한 기준으로 추출된다.

교차로 상황에서는 신호등이 교차된 4개의 지점에 존재하고 보행자 신호등 또한 각 지점마다 1개씩 존재하기 때문에, 카메라 인식 알고리즘에서 출력되는 데이터들 중 “traffic light”라는 이름으로 존재하는 데이터는 이론적으로 8개가 된다. 따라서, 이 데이터들 중, 자차량의 거동 및 주행 상황에 주된 영향을 미칠 신호등인 전방 차선의 교차로 신호기를 인식하기 위해 자차량의 위치 정보를 반영한다. 자차량 기준 전방 신호기는 카메라 화면의 x 좌표의 중앙 지역에 존재하며, 이는 픽셀 좌표계 형태의 가운데 부분에 해당한다.

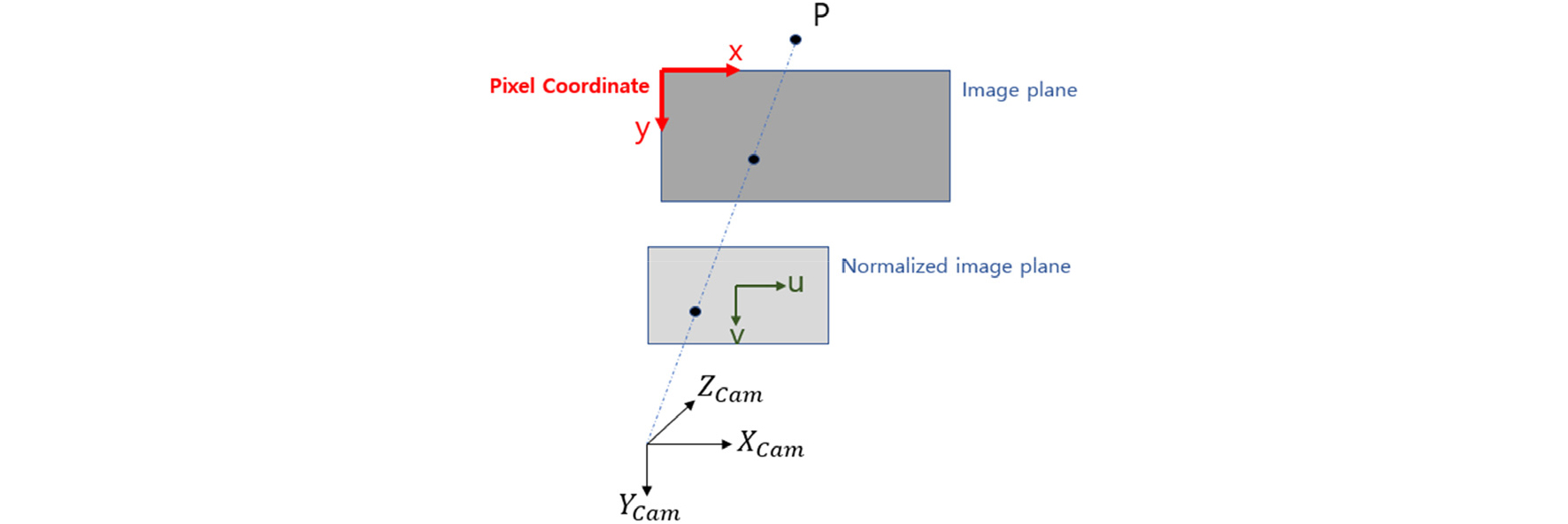

픽셀 좌표계는 Fig. 2와 같이 나타난다. 해당 실험에 사용된 픽셀 좌표는 960*540행렬의 형태로 존재한다. 따라서 전방에 잡히는 다수의 교통 신호기 중, 자차량의 교통에 주된 영향을 미칠 전방 신호기 추출은 차량의 가로방향에 해당하는 픽셀 좌표계 x값의 범위 480±40 사이에 존재하는 “traffic light” 객체들만 선별하는 것으로써 진행된다. 해당 프로세스를 통해, 자차량 전방에 존재하는 교통신호기만을 온전히 추출하게 된다.

3.2. 전방 교차로 신호 색 인식

3.1을 통해 추출된 전방 신호기 이미지 데이터는, 카메라 시점에서 보이는 바운딩박스 크기에 해당하는 행렬로 존재하며, 각 행렬 원소는 R, G, B 3개의 값으로 구성되어 있다. 따라서 전방 교차로 신호기의 색은 해당 넓이 개수만큼의 R, G, B값이 존재한다.

신호등 색 판단은 자차량의 직진 가능 여부를 목적으로 하였다. 따라서, 전방 신호기가 녹색 신호의 경우와 이외의 경우로 분류하였으며, 좌회전의 경우는 위의 분류기준에 따르면 직진 가능하지 않는 것이기 때문에 녹색 이외의 경우로 분류하였다.

전방 신호기가 녹색 신호인 경우에 대한 각 픽셀의G값을 합산한 후, 픽셀의 수로 평균한 결과는 Table 2와 같다.

시행 횟수마다 전방 신호기 픽셀에 대한 G값의 평균을 구한 후, 그 값들의 평균값을 구한 위의 결과는 63.2이다. 이러한 시행을 한 주행 구간에서 반복하여 실행한 결과 최종적으로 정한 기준값은 65로 하였다. 따라서 기준값보다 높은 값을 가지는 픽셀 데이터에 대해선 직진 가능한 값인 1을 출력하게 하였고, 기준값보다 낮은 값을 가지는 픽셀 데이터에 대해선 직진 불가능의 의미를 가진 0값을 출력하게 하였다.

이 과정을 통해, 주어진 상황에서 전방 교차로 신호기의 색이 직진 가능한지 아닌지에 대해 프로세싱하는 알고리즘을 개발한다.

해당 알고리즘은 실제 차량에 적용 가능한 부분이어야 하기 때문에 연산가능한 여부에 대한 확인을 위해 해당 알고리즘의 최적화가 수반되었다.

3.3. V2X 기반 전방 교차로 신호 값 수신

전방 교차로 신호 값에 대한 정확한 측정은 바로 신호등과 차량이 직접 통신하는 V2X롤 통해 이뤄진다. 각 신호등은 부착된 V2X 단말기를 통해 차량에 있는 OBU와 통신한다. 통신 데이터 규약은 Table 3과 같다.

이러한 통신은 교차로 4개의 신호등에서 모두 나오는 값을 수신하게 되므로, 받은 데이터 중 목표하는 전방 교차로의 신호가 어떤 것인지에 분류하는 과정이 필요하다.

이를 위해 V2X 단말기와 통신하는 데이터에서 시험환경의region ID에 해당하는 데이터만을 추출한다. 이후, 전방 교차로 신호에 해당하는 부분을 분류한 후, 그 부분에서 신호등 색에 해당하는 데이터만을 최종적으로 추출한다. 그 데이터가 직진에 해당하는 3인 경우 직진 불가능의 의미를 가진 0으로 출력하였고, 그 데이터가 직진에 해당하는 5인 경우 직진 가능의 의미를 가진 1로 출력하였다. V2X데이터를 가공한 이 값은 신호 색 인식 알고리즘 결과값의 ground truth 값으로써 적용된다.

4. 신호기 색 인식 시뮬레이션 결과

본 연구에서 제안한 학습된 데이터를 이용한 교차로 신호등 색 인식 알고리즘을 위해 서울대학교 미래 모빌리티 기술 센터(FMTC)에 위치해 있는 트랙에서 자율주행 실차 주행을 진행하여 카메라와 V2X 데이터를 취득하였다. 이후 취득 데이터 기반 오프라인 시뮬레이션을 진행하였다. 전방 교차로 신호기의 색 인식이 정확이 진행되는지를 확인하기 위해 V2X 데이터 와 비교하여 검증하였고, 3.2에서 언급했듯이 실차 수준 성능 확보를 위해 알고리즘의 연산 시간을 확인함으로써 실시간 연산 가능 여부를 검증하였다.

4.1. 전방 교차로 신호기 색 인식 결과

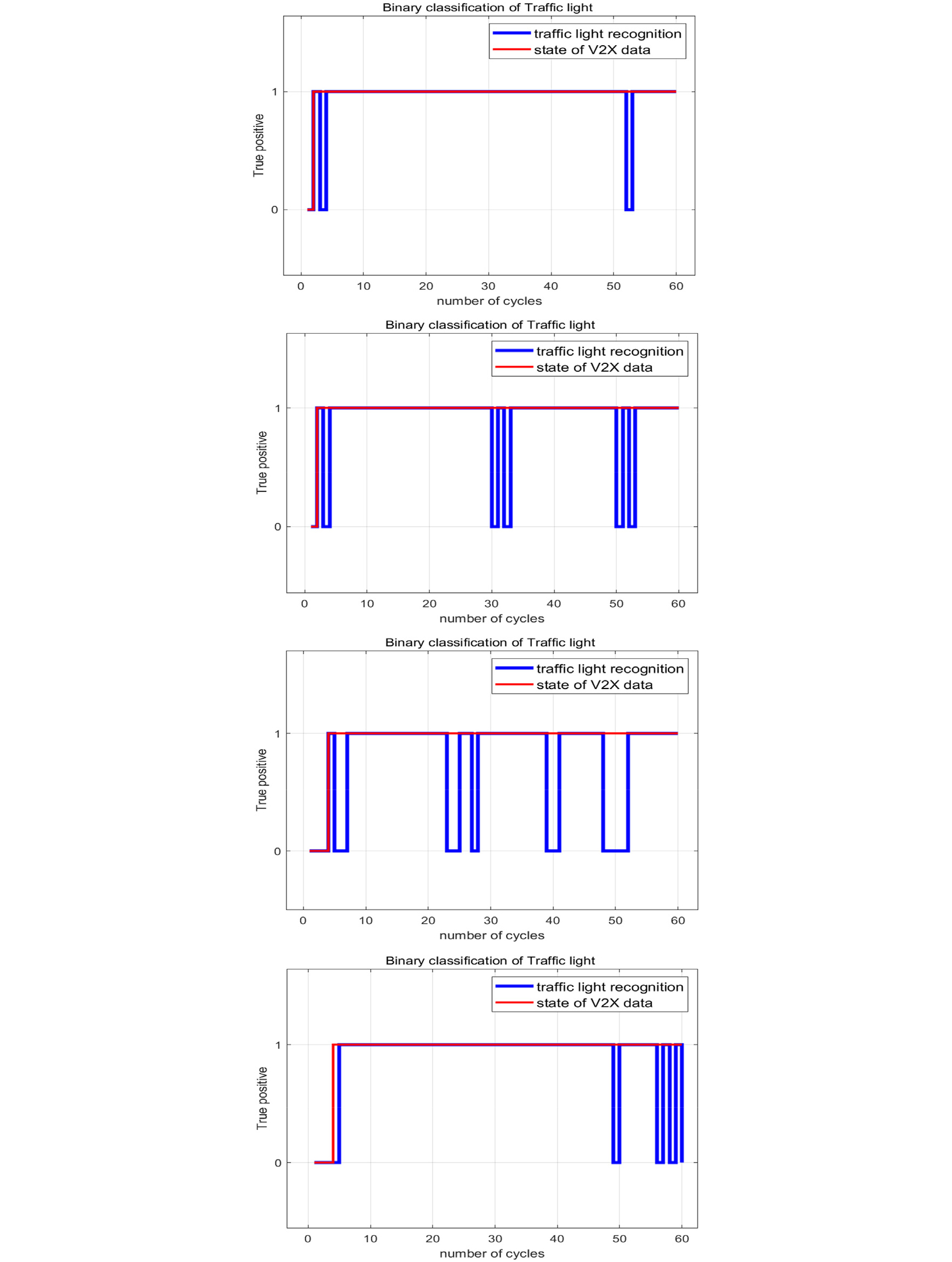

카메라를 통해 자차량의 교통방향에 해당하는 신호등 색 인식 결과는 Fig. 3에 나타내었다. 전방 신호기가 녹색불로 바뀐 것은 V2X 데이터를 통해 확인되며, 신호 색이 바뀐 후 2cycle 정도 후에 전방 신호기의 녹색불을 인식하는 것이 확인된다. 또한 해당 알고리즘이 전방의 녹색 신호를 지속적으로 인식하는 결과가 나타남을 알 수 있다. 4가지의 경우 모두 초반과 마지막에 인식 결과가 진동하는 것을 볼 수 있는데, 이는 초반의 경우, 전방의 교통신호기가 자차량에 비해 멀리 있어서 각 픽셀값의 G값이 작게 측정되어서 3.2에서 설정한 기준값을 넘기지 못하기 때문으로 추정된다. 그리고 후반의 경우는 시간이 지나 처음의 녹색불이 적색불로 바뀌었을때, 차량이 신호기에 근접해 있으므로 적색불에서 나오는 G 값 또한 큰 값을 가지게 되어, 그 결과 기준값을 넘김으로써 청색불로 오인식하게 되기 때문으로 추정된다. 이렇게 초반과 마지막의 경우의 결과값이 진동하는 것 이외의 경우에는, 전체적으로 전방 신호기의 색 인식율이 높음을 확인할 수 있다.

4.2. 신호 인식 알고리즘 연산 시간 결과

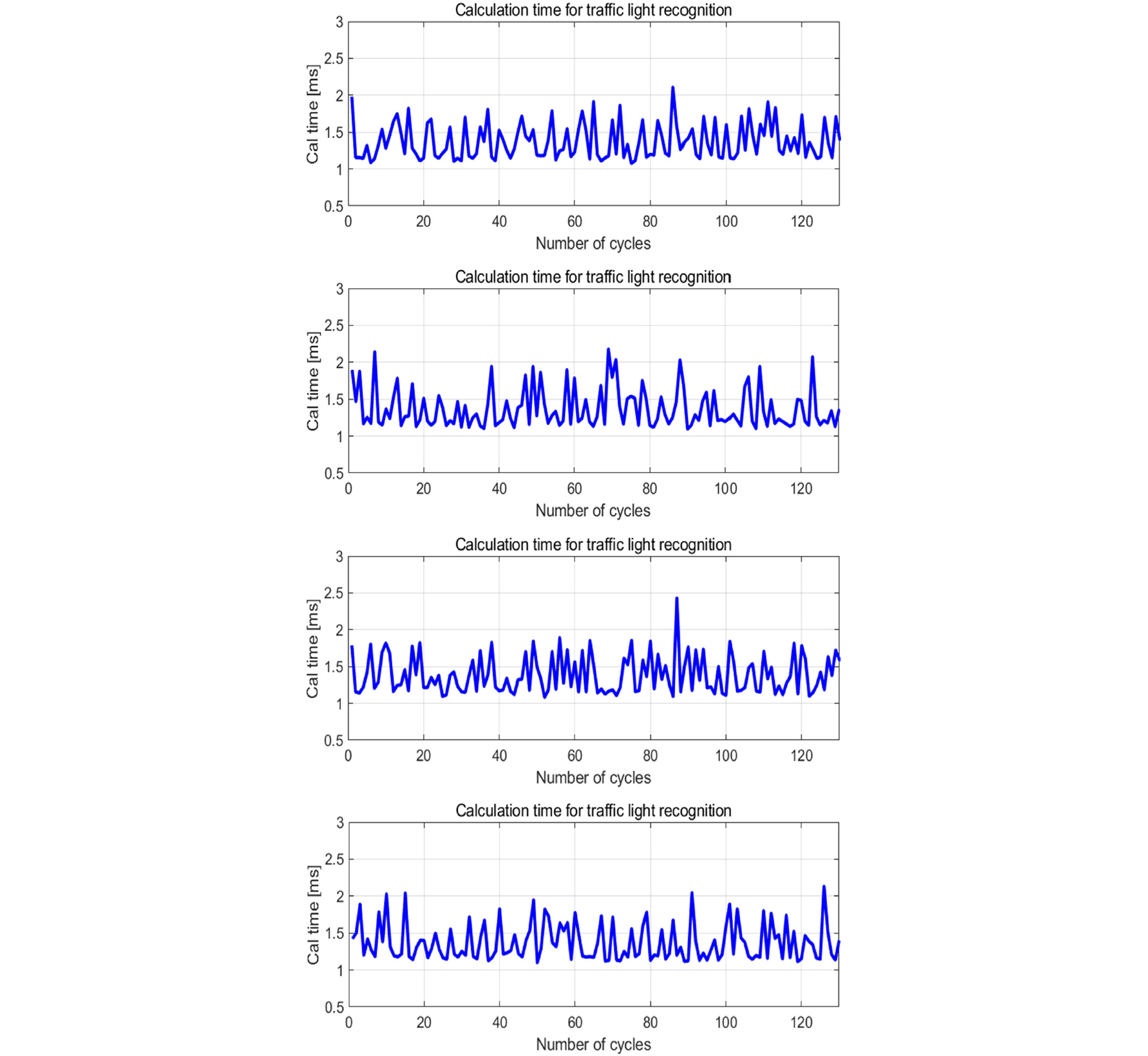

시뮬레이션 결과에서 측정된 연산시간은 Fig. 4에 나타내었다. 각 시뮬레이션에서의 연산시간을 평균한 결과는 1.37ms 정도로 구해진다. 기존의 자율주행 차량의 인식 알고리즘은 40ms정도로 계산되므로, 제안된 교통신호기 인식 알고리즘의 연산 시간은 전체 인지 알고리즘의 시간 증가량을 최소화하는 크기임을 알 수 있다. 따라서, 해당 알고리즘은 실제 자율주행 차량에서 가동하기 충분한 시스템으로 여겨진다.

5. 결 론

본 연구에서는 전방 교차로 신호기 색 인식 알고리즘을 다루었다. 비전을 통해 현재 교통 흐름을 알려주는 신호등 정보를 전달받아 주어진 신호기의 색을 인식하였으며, 인식한 정보를 검증하기 위해 V2X 데이터를 신호기 색 참값으로 설정하여 시뮬레이션을 진행하였다.

실험 결과 주어진 교통 신호기 색 인식에 대한 높은 정확도를 확인하였으며, 자율주행 실차로의 적용 가능성 또한 확인하였다.

이러한 전방 목표 신호기 추출 방법에서 나아가, 자차량 양 옆의 차선정보를 이용한 목표 신호기 추출 방법 및 신호 값 분류 기준 상세화를 통해 해당 알고리즘의 고도화를 추후 진행할 계획이다.